Contexte : Afin de mieux évaluer l’aléa sismique ou les ressources énergétiques du sous-sol, il est crucial de pouvoir avoir accès aux propriétés du milieu, à sa composition minéralogique et thermique. Dans ce but il est nécessaire d’imager les structures géologiques et leurs taux de saturation en fluide à différentes échelles : échelles de la lithosphère, de la croûte terrestre, de la proche surface (<200m), du laboratoire (métrique).

Nous accentuerons nos efforts dans le développement de techniques d’imagerie basées sur des inversions conjointes de données diverses correspondant à des physiques différentes et adaptées aux échelles spatio-temporelles étudiées. Ces outils seront appliqués d’ici 5 ans aux échelles de montagnes et de la lithosphère (gravimétrie et sismique dans les Pyrénées ou les Andes) jusqu’à la proche surface et la zone critique (sismique, résistivité électrique, micro-gravimétrie, …), voire à l’échelle du laboratoire.

1) Caractériser la proche surface par techniques de Deep learning

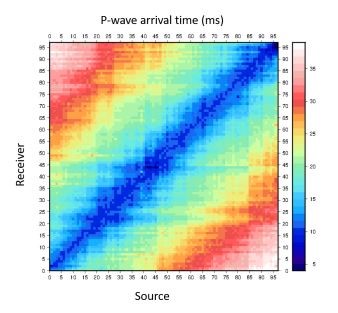

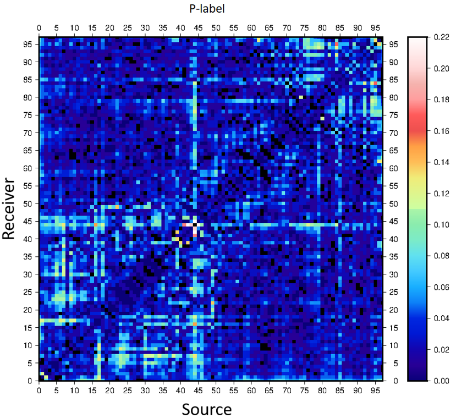

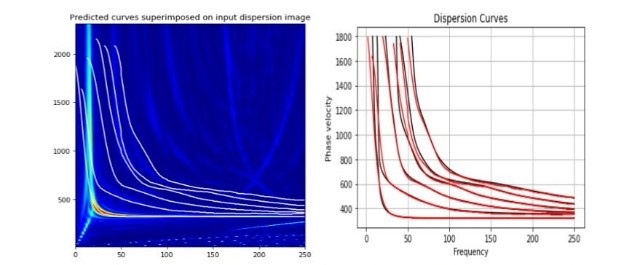

Pour mieux caractériser la proche surface, nous utiliserons différentes techniques de traitement de données nécessaires que ce soient des méthodes de Deep-learning ou d’inversion de données. Afin de traiter des données massives de bonne qualité des techniques de «Deep learning » seront utilisées. Pour estimer les incertitudes sur les modèles a priori et a posteriori, des techniques de classification par « machine learning » hybride supervisée seront effectuées. Elles permettent par exemple d’extraire les premiers temps d’arrivée d’ondes sismiques mais aussi les courbes de dispersion en vue de les inverser et de caractériser le sous-sol. Sur le long terme, un suivi temporel des fluides est aussi envisagé aux échelles de la proche surface près de zones fluviales, dans des bassins versants ou en zone côtière.

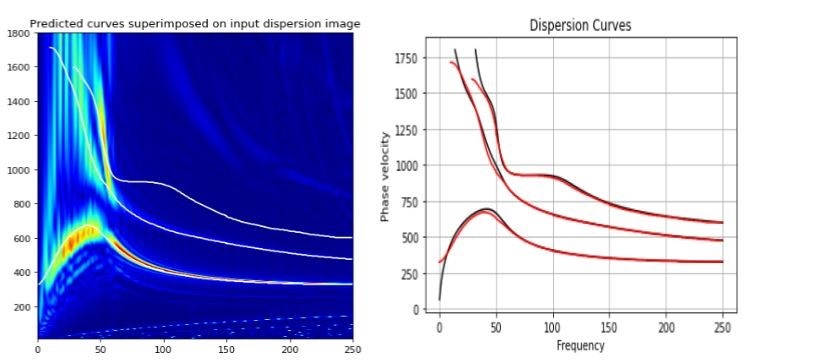

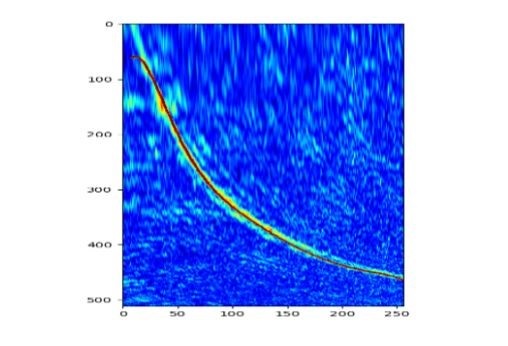

Des codes de calcul de type éléments spectraux (Specfem2D/3D) et de différences finies (SEISMIC_CPML,UNISOLVER, TOMOFAST-x) seront utilisés pour le problème direct et le problème inverse. En particulier, les codes de propagations d’onde ont la capacité d’intégrer les phénomènes d’atténuation, d’anisotropie ainsi que la poroélasticité pour mieux décrire la complexité du milieu. Ils permettent notamment de générer des bases de données de sismogrammes et de diagrammes de dispersion en vue de détecter les temps d’arrivée et des diagrammes de dispersion à différentes échelles. Des algorithmes de Deep-Learning supervisé par réseaux de neurones de type CNN sont utilisés pour la segmentation et la classification en vue d’effectuer ces détections de manière automatisée et rapides. Ils sont appliqués à des données pour des configurations métriques à kilométriques. Des techniques d’inversion performants seront ensuite appliqués à ces données pour caractériser le sous-sol et assurer son suivi temporel en présence de fluide (nappes, karsts,..) par exemple.

Figure : (A) Matrice de compatibilité/erreurs des temps d’arrivée entre sources et récepteurs à l’échelle de la proche surface (Huynh et al. 2023) en présence de topographie : 96 sources et 96 récepteurs, modèle de 100m de long. (B) Extraction automatique de 6 modes dans les diagrammes de dispersion dans un milieu stratifié (C) 3 modes extraits dans le même milieu stratifié en présence de karst à 10m de profondeur (D) Extrait du mode fondamental de données réelles bruitées pour un contexte semblabel d’acquisition des données que les cas synthétiques.

2) Modélisation gravimétrique et inversions conjointes :

applications aux Pyrénées et la France entière mais aussi à d’autres zones orogèniques (Andes,), ou encore le Groenland ??? (R. Martin, L. Seoane, M. Llubes, …). Des parties à mettre dans les parties imagerie avec Sébastien et d’autres avec M. Llubes, Lucia ou tout ensemble quelque part …

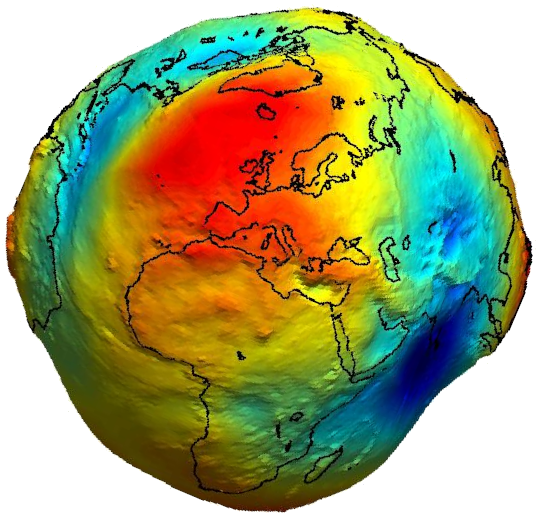

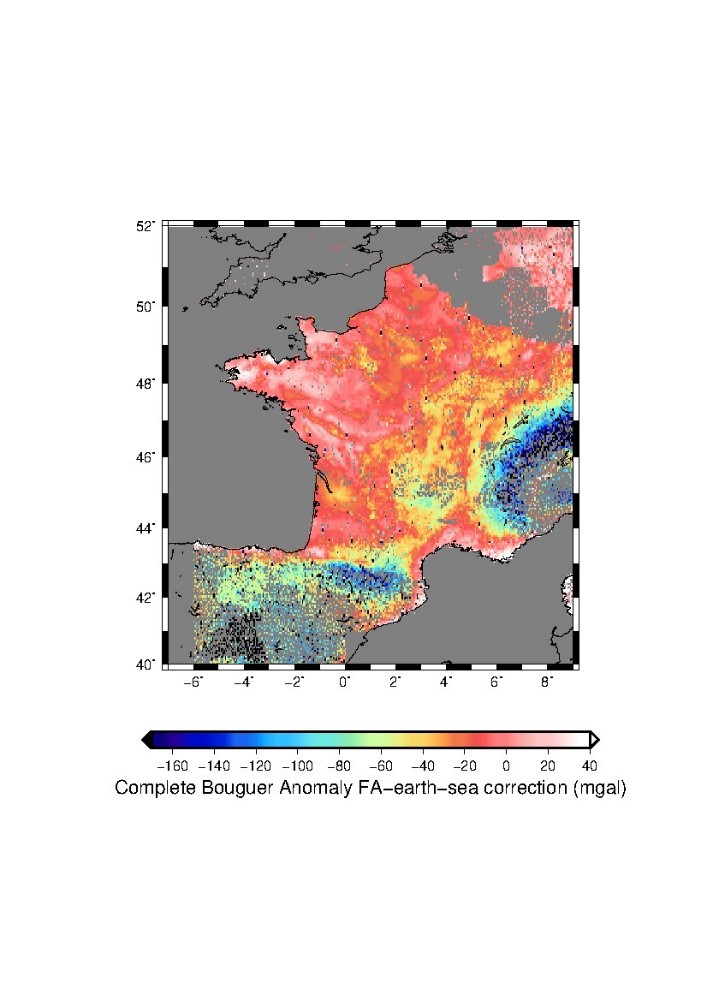

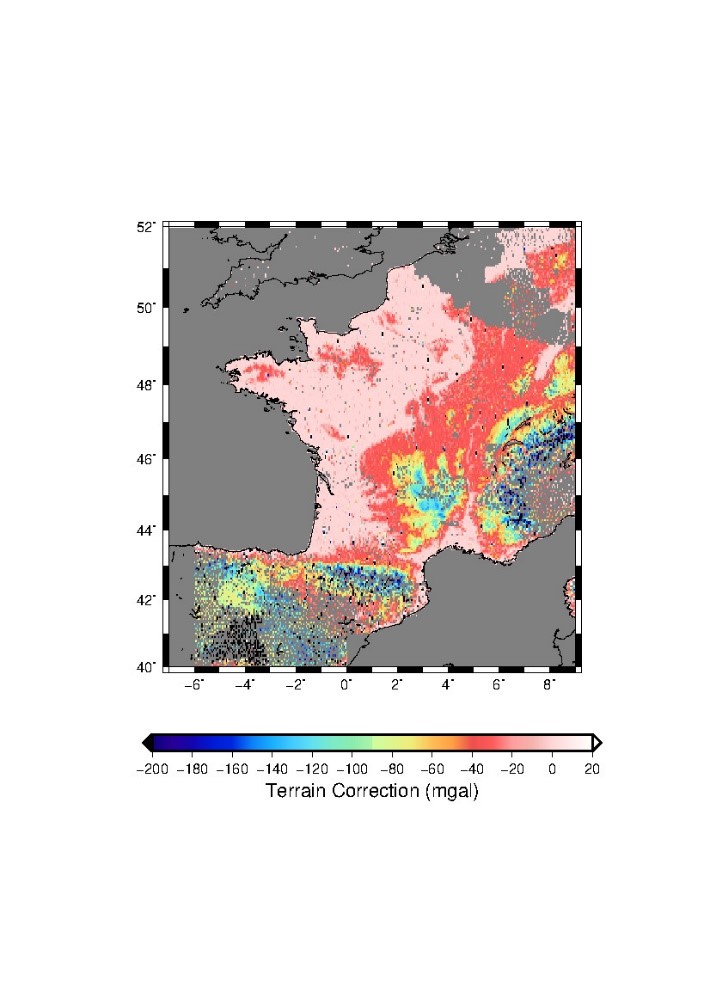

Dans le contexte actuel de respect de l’environnement et de demandes énergétiques accrues, une meilleure description du sous-sol à différentes échelles est nécessaire afin de mieux comprendre non seulement les processus géodynamiques mais aussi pour mieux définir la composition du sous-sol aux échelles lithosphériques et détecter des ressources naturelles non-carbonées. Des techniques de modélisation directe par élément spectraux et/ou blocs solides seront développées et utilisées pour la modélisation gravimétrique des Pyrénées et de la France entière à des résolutions de 900m à 80km afin de mieux résoudre les densités du sous-sol. Les zones orogéniques en particulier seront étudiées. Des inversions conjointes de données sismique set gravimétriques seront effectuées afin d’obtenir des modèles cohérents des densités et vitesses sismiques et Vs aux différentes échelles. Les données sismiques pouvant être les temps d’arrivée des différentes phases sismiques, les formes d’ondes ou des diagrammes de dispersion, etc… De plus la cohérence avec des modèles géologiques existants (BRGM, etc…) devront être pris en compte.

Des codes par éléments spectraux 3D sont utilisés pour calculer les données gravimétriques en épousant au mieux la topographie et les interfaces du milieu étudié à haute précision (modèle GEBCO à 15s et 1mn). Des codes d’inversion conjointe sont mis en place par éléments spectraux, par différences finies (UNISOLVER) ou encore par blocs rigides (TOMOFAST-x) avec différentes fonctionnalités permettant de prendre en compte les données géophysiques, géologiques et pétrophysiques.

Figure : Anomalies gravimétriques calculées par éléments spectraux à l’échelle de la France et la correction terrain associée pour un modèle bathymétrique et topographique GEBCO à 1mn de résolution et ~600 000 données du BGI (Martin et coll. 2023).

3) Techniques numériques (A compléter…)

Des techniques diverses (éléments finis, spectraux ou non, volumes finis, différences finies d’ordre élevé, …) seront utilisées et portées sur des plateformes de calcul haute-performance (locales à européennes Tier-0) avec des technologies diverses (CPUs, ARM, GPUs, …)